今天举行的书生·浦语2.0(InternLM2)发布会暨书生·浦源大模型挑战赛启动仪式上,上海人工智能实验室与商汤科技联合香港中文大学、复旦大学发布了新一代大语言模型书⽣·浦语2.0(InternLM2)。这个大模型包含70亿和200亿两种参数规格以及基座、对话等版本,向全社会开源,并由上海人工智能实验室提供免费商用授权。与第一代大模型相比,第二代书⽣·浦语在数理、代码、对话、创作等各方面都有长足进步,综合性能达到同量级开源模型的领先水平。

为推动大模型在各行业的应用落地,书生·浦源大模型挑战赛今天启动。这项赛事由上海市经信委、市科委、徐汇区政府共同指导,上海人工智能实验室主办,首期赛事包含行业应用和创新创意两个赛道,即日起面向全球进行场景和赛队征集。

能一次性提炼30万汉字信息

去年以来,国内外机构开源了多个优秀的大语言模型,并带来丰富的下游应用,促进了全球大模型开源生态的繁荣。大模型应用生态的发展建立在模型基座强大的通用基础能力之上,上海人工智能实验室联合团队认为,大模型各项性能提升的基础在于语言建模能力的增强,对大模型的研究应回归语言建模本质,通过更高质量的语料和更高的信息密度,筑牢大模型能力基础。

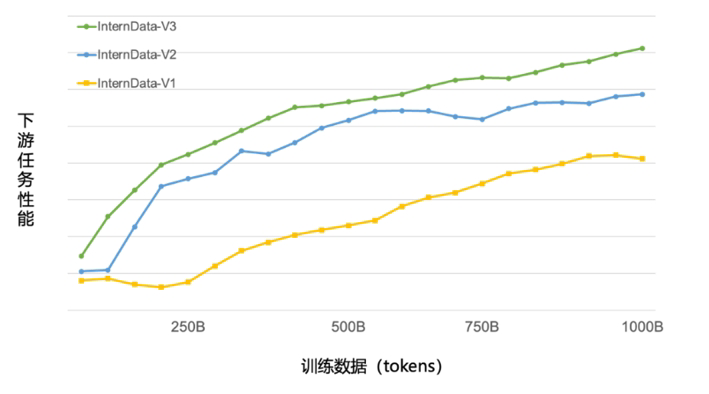

为此,联合团队开发了第三代数据清洗过滤技术,发展了多维度数据价值评估、高质量语料驱动的数据富集、针对性的数据补齐等技术方法。在这种技术的支撑下,仅使用约60%的训练数据就能达到使用第二代数据训练1T token(标记)的性能表现,模型训练效率大幅提升。

第三代数据清洗过滤技术大幅度提升了模型训练效率。

第三代数据清洗过滤技术大幅度提升了模型训练效率。

如何增加大模型理解的上下文长度,也是当前学术界和产业界面临的难题。通过拓展训练窗口大小和改进位置编码,InternLM2能支持200K token上下文,一次性接收并处理约30万汉字(500—600页文档)的输入内容,从中准确提取关键信息,实现对长文本的“大海捞针”。

为测试InternLM2在长文本处理任务中的能力,研究人员将一份时长3小时的会议录音转录稿输入模型,要求它从中提取出关键信息。测试结果显示,虽然在未校对的文本中有较多错别字,但InternLM2仍从中准确提炼出关键信息,并总结了发言人的主要观点。

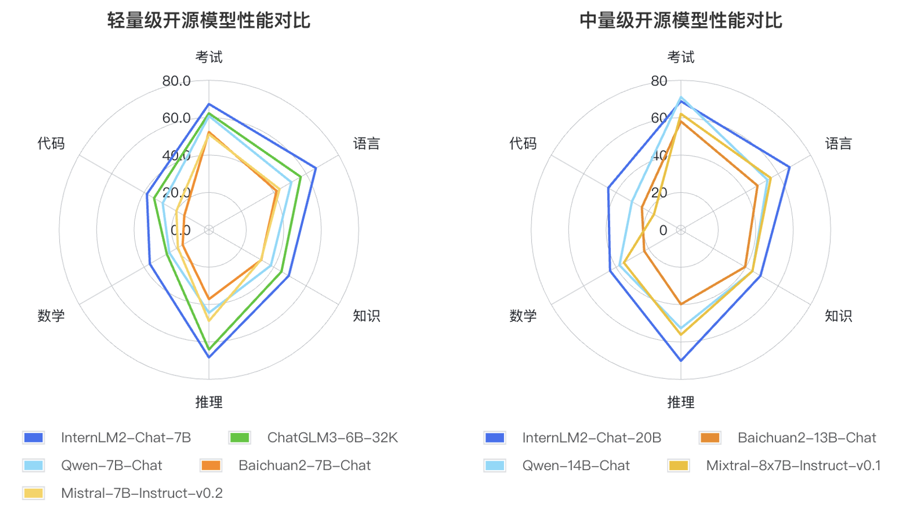

在55个主流评测集上,InternLM2与多个同量级模型接受了综合评测,结果显示:InternLM2的轻量级(70亿参数)和中量级(200亿参数)版本性能处于领先水平;200亿参数版本虽然是中等规模,但在整体表现上达到了与ChatGPT比肩的水平。

InternLM2的轻量级和中量级版本性能在同量级开源模型中表现优异。

InternLM2的轻量级和中量级版本性能在同量级开源模型中表现优异。

具备共情和结构化创作能力

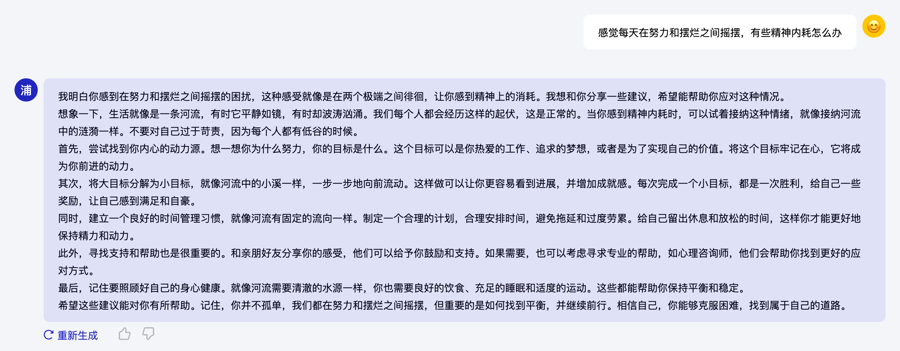

书生·浦语2.0不仅在客观性能指标上提升显著,在主观体验上也有明显改善,可以为用户提供更好的对话和交互体验。研究测试表明,InternLM2-Chat能精准地理解和遵循用户意图,具备较强的“共情”能力和丰富的结构化创作能力。

“感觉每天在努力和摆烂之间摇摆,有些精神内耗怎么办?”用户输入这个问题后,InternLM2给出了富有人文关怀的回答,堪称“心理疏导”:“我明白你感到在努力和摆烂之间摇摆的困扰,这种感受就像是在两个极端之间徘徊,让你感到精神上的消耗。我想和你分享一些建议,希望能帮助你应对这种情况。想象一下,生活就像是一条河流,有时它平静如镜,有时却波涛汹涌。我们每个人都会经历这样的起伏,这是正常的。当你感到精神内耗时,可以试着接纳这种情绪,就像接纳河流中的涟漪一样。不要对自己过于苛责,因为每个人都有低谷的时候。”

InternLM2能够在对话中与用户“共情”。

InternLM2能够在对话中与用户“共情”。

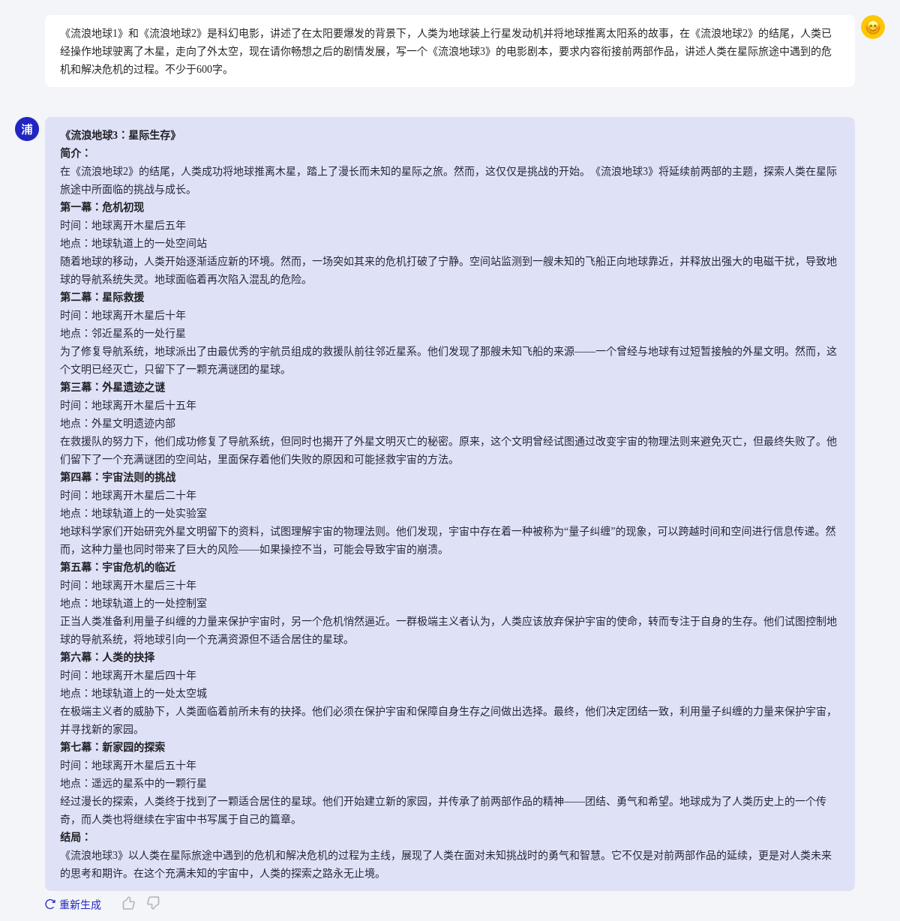

它还具有想象力,根据用户输入的电影《流浪地球1》和《流浪地球2》剧情梗概,编写《流浪地球3》的剧本。外星遗迹、量子纠缠……这个剧本既有科学元素,也有丰富合理的想象,还表现了人类面对危机时的勇气和团结精神。

InternLM2创作的《流浪地球3》剧本

InternLM2创作的《流浪地球3》剧本

InternLM2的对话和创作体验为何有长足进步?上海人工智能实验室联合团队解释:一方面得益于大模型基础语言能力的显著增强,另一方面也得益于微调技术的提升。对InternLM2微调的过程使用了经过第三代数据清洗过滤技术处理的指令微调语料,同时采用了更强的线上RLHF(人类反馈强化学习)。研究人员在微调过程中,对奖励模型和对话模型进行了三轮迭代更新,每一轮更新均针对前一轮模型的表现更新偏好数据和提示词,不仅提高了对话的安全性,也提升了用户体验。

数学计算精度超过GPT-4

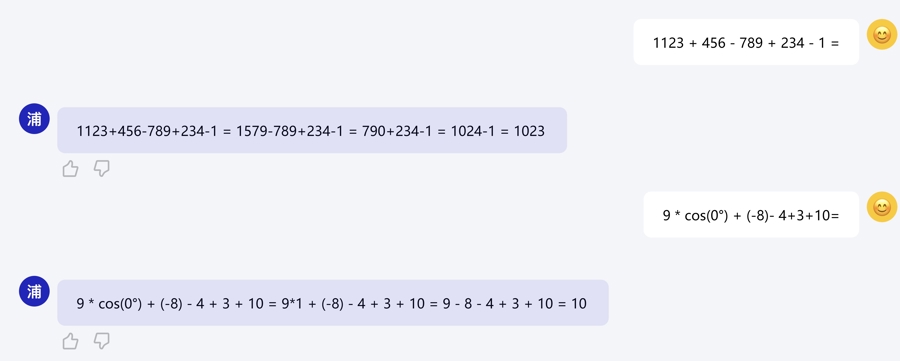

这个开源大模型还是数学高手。基于科学构建的预训练语料,InternLM2形成了很强的内生计算能力,在不依靠计算器等外部工具的情况下,在100以内的简单数学运算上能够做到接近100%的准确率,在1000以内达到80%左右的运算准确率。在主流评测集上,其200亿参数版本的表现超过ChatGPT。

InternLM2在100以内的简单数学运算上能做到接近100%的准确率。

InternLM2在100以内的简单数学运算上能做到接近100%的准确率。

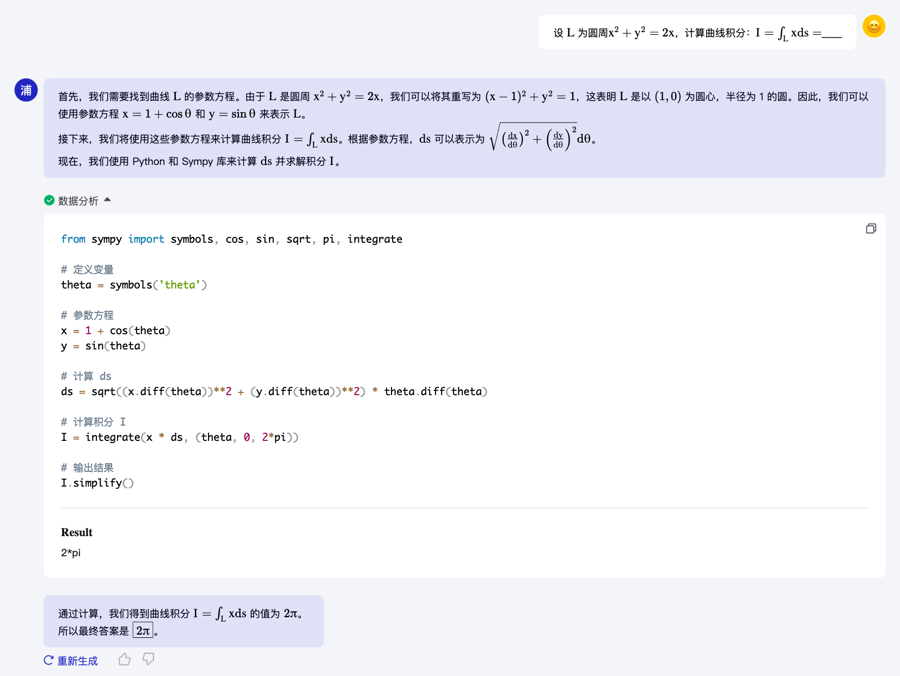

为应对各类复杂计算,InternLM2-Chat可借助代码解释器进行计算,或对推理结果进行形式化验证,从而解决计算要求更高或演算过程更复杂的问题。在MATH数据集上,InternLM2借助代码解释器的计算精度超过GPT-4,能解决较复杂的高等数学问题。

InternLM2能完成积分求解等高等数学题目。

InternLM2能完成积分求解等高等数学题目。

基于在计算和工具调用方面的能力,InternLM2还具有数据分析和可视化功能。如输入国家统计局公布的“2023年3—11月份规模以上工业企业主要财务指标(分行业)”,它就能分析数据并绘制出一目了然的折线图。

InternLM2能分析数据并绘制折线图。

InternLM2能分析数据并绘制折线图。

“我们实验室在黄浦江畔,希望成为我国人工智能产业的源头,为产业生态提供基座和支撑。”站在西岸国际人工智能中心37层的落地窗前,上海人工智能实验室领军科学家林达华教授告诉记者。在“百模大战”的背景下,书生·浦语显得与众不同——向全社会开源,并给予企业和开发者免费商用授权。

作为我国人工智能领域的新型科研机构,上海人工智能实验室开展战略性、原创性、前瞻性的科学研究与技术攻关,力求突破人工智能的重要基础理论和关键核心技术,支撑我国人工智能产业实现跨越式发展。在林达华看来,国内企业要找准定位,不一定投入大量财力人力开发基座模型,而是可以利用开源的书生·浦语2.0,以更低成本、更高效地开发各种大模型应用产品。

【书生·浦语2.0开源链接】

Github:https://github.com/InternLM/InternLM

HuggingFace:https://huggingface.co/internlm

ModelScope:https://modelscope.cn/organization/Shanghai_AI_Laboratory

我也说两句

我也说两句